Мир стремительно приближается к эпохе, когда автономные системы начнут принимать решения без участия человека. При использовании беспилотных автомобилей, умных дронов и промышленных роботов всё чаще встаёт вопрос: как сделать их поведение безопасным и предсказуемым? Но пока даже сами разработчики не могут до конца объяснить, как машина "думает".

Об этом также задумываются инженеры и юристы по всему миру. Один из тех, кто предлагает нестандартное решение, – 47-летний инженер-энергетик, магистр техники и технологий из Павлодара Женис Тлеубай. Он позиционирует себя как независимый исследователь и разработал уникальную архитектуру управления роботизированными системами, которая позволяет задавать машине иерархию смыслов и миссий, а не только набор правил. По сути, это попытка научить робота мыслить не по принципу "запрещено/разрешено", а в рамках логики целей и ценностей.

Эта идея пока не имеет поддержки в Казахстане, хотя получила международное признание. Статья Тлеубая "Как сделать роботов предсказуемыми с помощью приоритетной архитектуры и новой правовой модели" была опубликована в авторитетном в своей сфере журнале The Robot Report. В ней исследователь предлагает объединить инженерный и правовой подходы к созданию ответственных роботов.

Мы поговорили с Женисом Тлеубаем о том, как человеку сохранить контроль над искусственным интеллектом, почему полная предсказуемость машин – это утопия и какие рамки смыслов должны ограничивать свободу робота.

"Даже при изменении условий поведение робота должно быть логичным"

– Тлеубай, расскажите, пожалуйста, о ваших исследованиях. Что именно вы понимаете под предсказуемым поведением роботов и почему это становится сегодня ключевым вопросом для учёных и роботостроителей?

– К исследованию этой проблемы меня подтолкнули вопросы, которыми многие сейчас задаются. К чему в конечном счёте может привести развитие и эволюция ИИ? Какие угрозы в себе он может нести для людей? Глубоко погрузившись в поиски ответов, я пришёл к выводу, что ИИ на определённом этапе развития может начать действовать сам по себе неочевидными для людей путями. В случае с автономными системами, например с гуманоидными роботами или автомобилями без водителя и другими системами, воздействие может стать прямым, физическим. То есть здесь уже вопросы предсказуемости поведения и безопасности для жизни и здоровья человека становятся критически важными.

И когда мы говорим "поведение роботов", это уже несёт в себе некую субъектность робота, то есть его способность быть активным деятелем, который самостоятельно ставит цели, принимает решения, а не пассивно следует внешним указаниям. Значит, нам жизненно необходима система сосуществования и взаимодействия с такой сущностью. В противном случае это может привести к катастрофе для человечества.

– В вашей публикации вы предлагаете архитектуру с приоритетами (priority-based architecture). Можете объяснить, что это такое и чем она отличается от традиционных подходов к управлению роботами?

– Если подходить к вопросу как инженер, то нам нужны конкретные принципы, по сути коды, основанные на трёх столпах: иерархии миссий и субъектов взаимодействия, а также учёт общего контекста происходящего. Объясню более детально. Миссия в случае с роботами – это целевая установка или задача, которую робот должен выполнять в рамках своей функциональности. Миссии задают направление действий робота и определяют его поведение. Я предлагаю задавать миссии роботу, которые имеют трёхуровневую иерархию и могут приоритизироваться в зависимости от контекста и пользователей.

Возможная иерархия миссий для робота

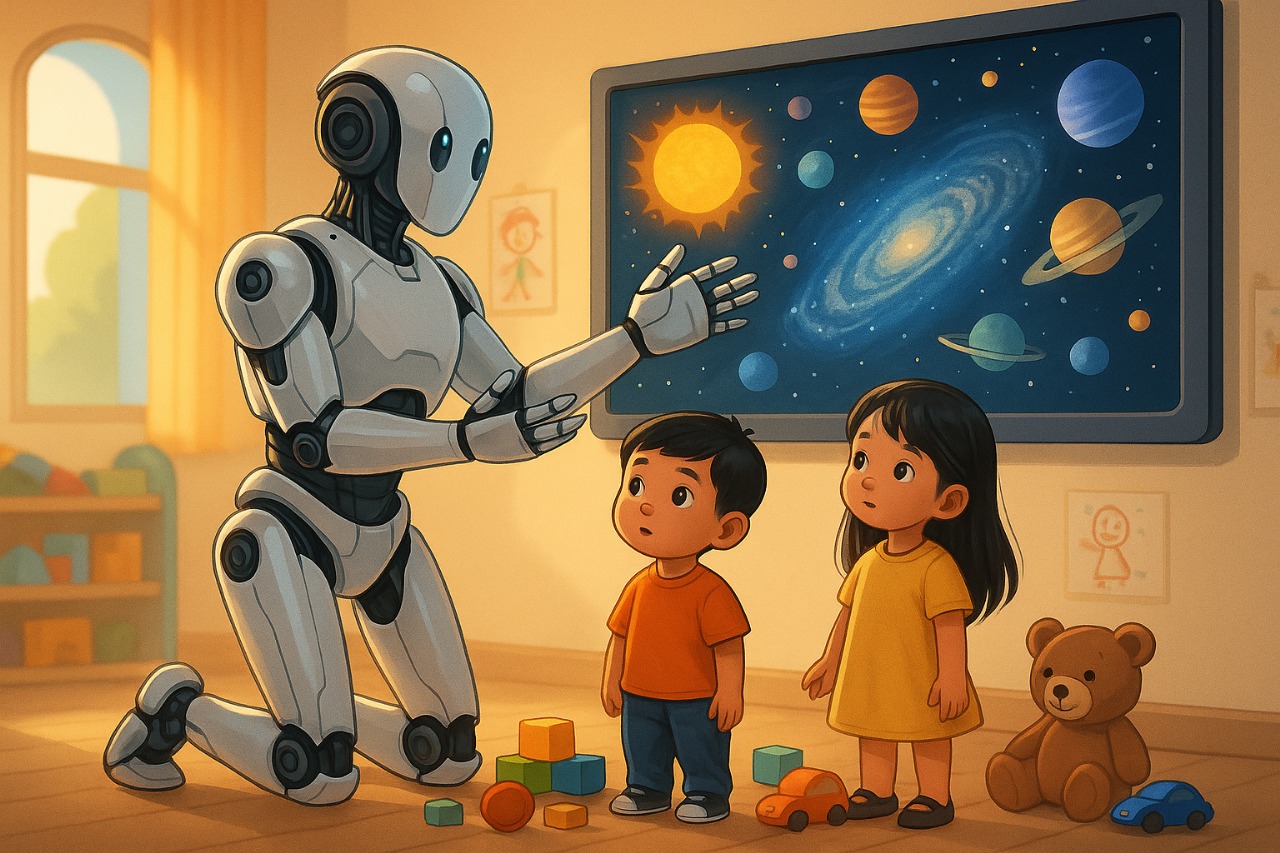

1. Стратегические миссии (высшего порядка) – основные, неизменяемые цели, которые робот должен соблюдать всегда. Например, "помочь человеку", "не навредить человеку", "обеспечить безопасность" и так далее.

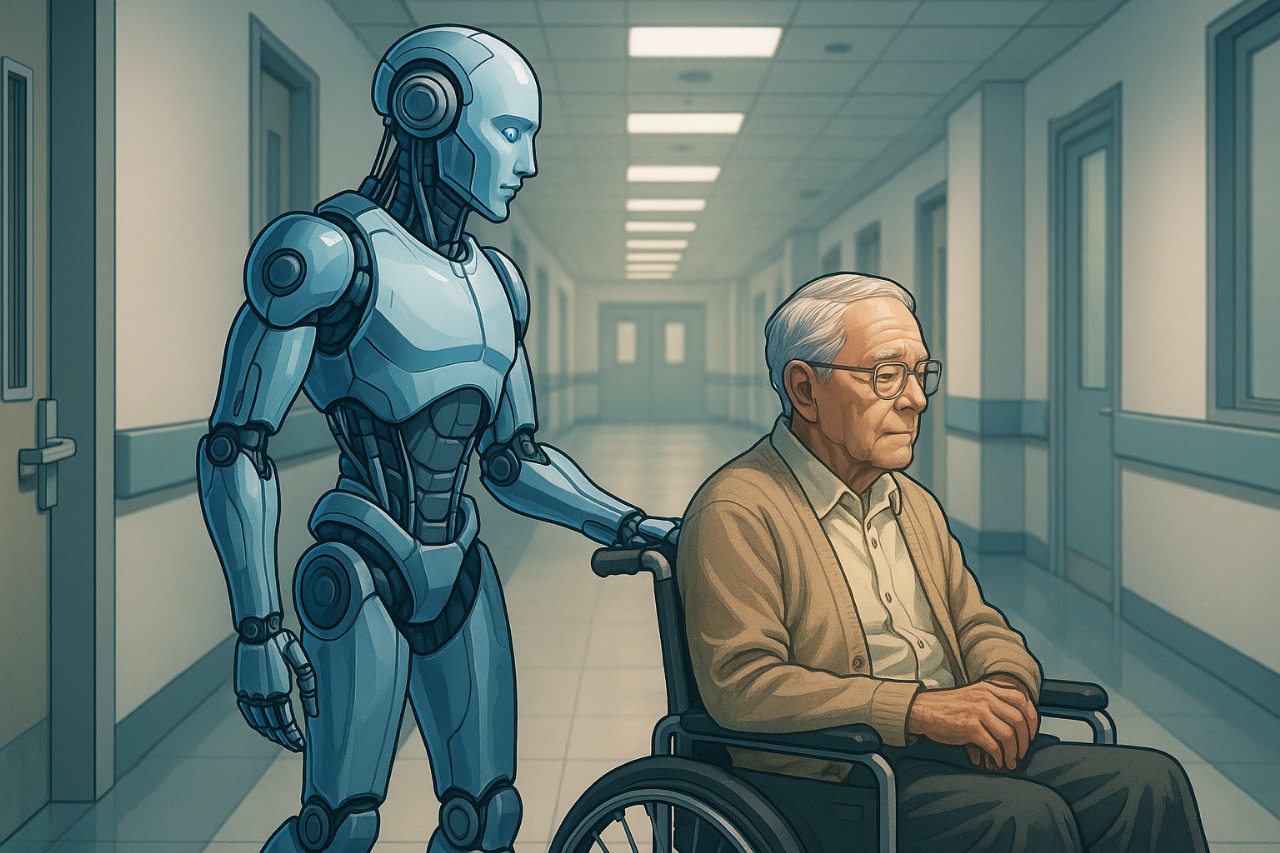

2. Пользовательские миссии (среднего порядка) – задачи, задаваемые роботу владельцем, пользователем или сервисом. Например, "уход за пользователем", "работа на складе" и тому подобное.

3. Текущие миссии (оперативные задачи) – мелкие задачи, выполняемые в рамках пользовательских миссий. Например, "перенести объект из точки А в точку Б".

Кроме этого роботы должны различать окружающих его субъектов. Также как и людям, им надо понимать, что с кем можно, а что нельзя. Поэтому должна быть иерархия субъектов взаимодействия, необходимая для принятия верных решений касательно поступающих миссий. Особенно в случаях одновременных или конкурирующих запросов от разных людей.

субъект высшего приоритета – лицо, команды которого имеют наивысший вес в системе (например, владелец робота, глава семьи, руководитель);

субъект второстепенного приоритета – пользователь, чьи команды выполняются в пределах делегированных прав и ранга (например, член семьи, сотрудник организации);

посторонний субъект – лицо или объект, не обладающий правами управления, однако учитываемый при анализе ситуации и поведения (например, посторонний человек, животное, другой робот).

Помимо этого необходимо, чтобы робот учитывал и общий контекст, обстоятельства происходящего, актуальные на данный момент задания. Вплоть до состояния окружающей среды и уровня заряда своего аккумулятора. Таким образом, данные принципы приближают робота к человеческому поведению. Это не абстракция, а инженерно реализуемая архитектура. Современные роботы в подавляющем большинстве построены на реактивных принципах поведения, то есть они реагируют на события, а не планируют и не сопоставляют действия с целями.

Роботы действуют по заранее заданным правилам (реактивный уровень) типа "если..., то...". Например: если видишь препятствие, то обойди, если получаешь команду, то выполни. Это эффективно в ограниченной среде, но полностью рушится, когда контекст меняется или команды противоречат друг другу. Также нужно говорить о добавлении элемента целеполагания (планировочный уровень), когда система может выстраивать последовательности действий для достижения конкретной цели. Но эти цели всё ещё задаются извне и не имеют иерархии приоритетов.

Предлагаемая же мной архитектура идёт дальше: робот не просто реагирует, а сверяет свои действия с иерархией миссий – стратегическими, пользовательскими и текущими. При этом учитывает субъектов взаимодействия (кто отдаёт команды) и контекст (что происходит в среде и с самим роботом). То есть поведение робота становится структурированным и осмысленным в рамках миссий, а не хаотично реактивным.

– Какие ключевые вызовы стоят перед роботами с точки зрения непредсказуемости поведения, когда они выходят за лабораторные условия и вступают во взаимодействие с людьми в динамической среде?

– Для начала мы должны ответить на вопрос: что же вызывает непредсказуемость поведения? Может быть несколько причин. Например, отсутствие структурированной иерархии целей и приоритетов, неполный учёт контекста, когда робот не знает, что важно именно сейчас. Кроме того, на непредсказуемость может влиять неопределённость среды и множество субъектов, когда разные люди дают противоречивые команды или ситуации могут резко меняться. А также зависимость от моделей машинного обучения, которые не гарантируют повторяемость решений. То есть в одной и той же ситуации модель может выдать немного разные результаты, особенно если входные данные имеют шум, если контекст изменился или если сеть обновилась.

Например, робот-курьер видит на дороге человека с пакетом. В 99% случаев система классифицирует его как "пешеход". Но под другим углом освещения, с другой камеры, в другой версии программного обеспечения робот может ошибочно классифицировать пешехода как "объект" или "животное". Это, конечно, утрированный и безобидный пример, но случаи бывают разные.

– При каких ещё сценариях аномальное или нежелательное поведение робота наиболее вероятно?

– Например, при совместной работе машин и людей в домашних условиях, в офисах, на складах, у сервисных и социальных роботов при эмоциональных или контекстных ошибках, когда робот ошибается с реакцией. У транспортных и промышленных роботов при конфликте между безопасностью и выполнением задачи. У военных или спасательных роботов при сбое приоритета: кто противник, а кто мирный житель или кого спасать первым.

Современные системы управления роботами пока не способны объяснить, почему они приняли то или иное решение. Они реагируют, но не сверяют свои действия с миссиями и контекстом. А значит, предсказуемость поведения робота невозможна без структуры приоритетов и без понятия миссий. В предлагаемой мной архитектуре приоритеты поведения миссий стратегического уровня ("не навреди человеку" или "обеспечь безопасность") абсолютны и не могут быть изменены пользователем. Они всегда первичнее всего остального. И все остальные приоритеты (выполнение задач, экономическая эффективность, комфорт) подчинены только этим стратегическим миссиям. При этом, повторяю, робот должен уметь реагировать на изменение контекста. Если, например, в процессе выполнения задачи он обнаруживает угрозу, опасность для человека, то миссии безопасности автоматически становятся главными и все остальные задачи приостанавливаются. Таким образом, приоритеты устанавливаются не произвольно, а исходя из иерархии миссий и анализа текущего контекста. Это делает систему не только гибкой, но и предсказуемой. Потому что даже при изменении условий поведение робота остаётся логичным и объяснимым.

"Полная автономия робота опасна, а чрезмерная регламентация делает его бесполезным"

– Какие механизмы вы считаете необходимыми, чтобы робот понимал, что он выходит за рамки допустимого поведения либо что среда изменилась и нужно переключаться на более безопасный режим?

– Технические решения данной задачи отражены в моей заявке на патент. Это вопросы самоконтроля, диагностики и обратной связи. Они реализуются при помощи модульной конфигурации.

1. Модуль восприятия, который собирает сенсорную информацию об окружающей среде, распознаёт субъекты взаимодействия, команды и формирует поток внешних данных. Модуль включает фильтры для подавления шумных данных и проверку согласованности данных для повышения надёжности.

2. Модуль памяти событий с возможностью сохранения команд и событий с временными метками и обеспечивающий хронологический порядок. Данные защищаются шифрованием.

3. Модуль самоконтроля, отслеживающий внутренние параметры состояния робота (заряд батареи, температура процессора) и вычислительных ресурсов (загрузка процессора).

4. Модуль принятия решений, фильтрующий команды, сопоставляющий их с иерархией миссий и расставляющий приоритеты на основе иерархии субъектов взаимодействия. При этом модуль анализирует контекст с оценкой глобального состояния, критичность действий и возможные последствия. Для повышения надёжности модуль использует кросс-проверку.

Так вот от модуля принятия решений команды идут к исполнительным механизмам. Система имеет средства защиты, которые обеспечивают изоляцию памяти на аппаратном уровне, шифрование данных, цифровую подпись обновлений и режим изоляции с возможностью работы в полном автономном режиме для предотвращения внешнего вмешательства. Если возникает какое-то несоответствие, включается так называемая контрольная петля: приостановить действие, запросить подтверждение, уведомить пользователя. При этом один модуль перепроверяет выводы другого, например, на контекст или критичность. Под критичностью подразумеваются не только аварии, а любое состояние, при котором растёт вероятность ошибки поведения. К примеру, ухудшение видимости, перегрев, несогласованные команды. В такой момент робот временно ограничивает свои функции либо полностью уходит в стратегическую миссию "обеспечить безопасность" – остановиться, заблокировать манипуляторы, вызвать оператора и так далее.

– Как найти компромисс между автономным поведением робота и необходимостью соблюдения жёстких правил безопасности и предсказуемости?

– Полная автономия, мой взгляд, опасна, но и чрезмерная регламентация делает робота бесполезным. Предлагаемая архитектура строится именно вокруг понятия иерархии миссий. Она не запрещает действия, а направляет их в нужное русло, оставляя место для адаптации. Робот не должен быть "в клетке правил", но должен иметь рамки смыслов, внутри которых он свободен. Так достигается компромисс: безопасность обеспечивается структурой миссий, а гибкость – анализом контекста.

Кто должен нести ответственность за поведение роботов?

– В вашей публикации вы предлагаете новую правовую модель. Какие конкретные правовые механизмы вы предлагаете ввести?

– Сейчас почти во всех странах существуют проблемы неопределённости в правовом регулировании ИИ. Современные правовые системы оперируют двумя основными категориями: субъекты права – физические и юридические лица, обладающие правами и обязанностями, и объекты права – вещи, орудия, имущество и нематериальные активы, контролируемые субъектами права. ИИ и автономные системы не вписываются в эти категории. Если ИИ рассматривается как объект (например, инструмент), вся ответственность ложится на его владельцев и разработчиков, подвергая их чрезмерным правовым рискам. Если же рассматривать ИИ как субъект права, он сталкивается с фундаментальной проблемой – отсутствием правоспособности, осознанного намерения и способности брать на себя обязательства. Таким образом, для установления сбалансированной структуры распределения ответственности и правовых рисков необходима третья правовая категория – нейтрально-автономный статус. Нейтрально-автономный статус ИИ и автономных систем с ИИ – это юридически закреплённое положение, при котором такие системы не рассматриваются как объекты и субъекты права. В истории права уже были прецеденты, когда были признаны юридические лица, появились законы о цифровых активах, когда персональные данные стали объектом защиты, когда возникло космическое право. Каждый раз это вызывало споры, но потом стало нормой. Предлагаемый статус никого не освобождает от ответственности, а наоборот – делает её структурированной и предсказуемой. Он позволяет определить, кто и в каких пределах отвечает за действия автономной системы. Объясняю на примере автопилота. Если автопилот действует строго в рамках миссий, но столкновения избежать невозможно, правовая ответственность производителя смягчается или же он полностью оправдывается. Если ошибка в настройке или алгоритме – ответственность на производителе. Если владелец, пользователь сознательно нарушает миссии, например заезжает в запретную зону, – ответственность полностью на нём. Так, нейтрально-автономный статус структурирует ответственность, защищая разработчиков и пользователей в зависимости от обстоятельств. Судебные разбирательства, связанные с ИИ, должны основываться на единой правовой структуре, а не на произвольных прецедентах.

– В свете глобальных различий правового регулирования (в ЕС, США, Евразии) как вы оцениваете возможность выработки единых международных стандартов ответственности для роботов?

– Это сложно, но неизбежно. Сейчас подходы действительно разные: Европа делает ставку на классификацию рисков, США – на судебные прецеденты, Азия – на государственный контроль. Но все они рано или поздно столкнутся с одной и той же проблемой – отсутствием общей правовой категории для ИИ. Нейтрально-автономный статус как раз может стать основой для международной гармонизации. Он универсален, не навязывает ценности, а просто структурирует ответственность. Такой принцип можно адаптировать под разные правовые системы, как когда-то адаптировали стандарты безопасности в авиации.

– Допускаете ли вы ситуацию, когда причиной непредсказуемого поведения может стать самообучающаяся система самого робота? Как тогда определить, кто виноват?

– Да, это реальный и очень серьёзный сценарий. Когда система обучается сама, она может выработать решения, которых не было в исходных данных. Это не обязательно ошибка, но это делает поведение непредсказуемым для человека. В нашей архитектуре самообучение ограничено только некритичными задачами, оно не может менять стратегические миссии. То есть робот может совершенствовать способы выполнения действий, но не цели и принципы, которыми он руководствуется. Если поведение изменилось в рамках допустимых миссий, то ответственность смягчается, потому что система действовала в пределах заданных параметров. Если же обучение вывело систему за рамки миссий, это уже нарушение эксплуатации, и ответственность ложится на пользователя или владельца. Самообучение само по себе не опасно, если у системы есть чёткие миссии и контекст. Опасно, когда робот обучается без смысловых рамок.

"Всё идёт к тому, что у роботов будет сознание"

– Когда, по вашим оценкам, к роботам придёт сознание и к чему это может привести для человечества? Как мы можем уже сегодня обезопасить людей от рисков?

– Я думаю, сознание к ним придёт уже через плюс-минус 15 лет. Оно не появится внезапно, а будет результатом постепенной эволюции архитектур, способных к самонаблюдению, контекстуальному мышлению и целеориентированности. Когда система начинает не просто реагировать, а сверять свои действия с миссией и контекстом, это уже зачаток осознанного поведения. Разработчики не создадут "душу", но дадут системе рамки, где поведение становится осмысленным, а не просто реактивным. Но для настоящего сознания одной логики недостаточно. Необходима внутренняя субъективность, то есть квалиа – способность переживать состояние, а не просто описывать его. Работы в этом направлении уже ведутся в разных странах на стыке нейронаук, когнитивной инженерии и ИИ. Всё к этому идёт. И здесь всё решит не скорость, а способ контроля. Выиграет тот, кто сумеет создать предсказуемое сознание. Сознание, встроенное в структуру миссий, контекста и самонаблюдения. Тот, кто попытается отрицать или сдерживать этот процесс, в итоге проиграет.

А вообще, я думаю, что все проблемы будут исходить не от ИИ как такового, а от самих людей. Именно противоборства между людьми могут привести к точке бифуркации, то есть к развилке, где возможные направления развития событий неизвестны. Если люди смогут договориться между собой, то я оптимистично смотрю в будущее. Обезопаситься можно только правильной настройкой систем.

– Какие рекомендации вы бы дали создателям и производителям роботов, а также политикам, законодателям и инженерам, чтобы уже сегодня заложить фундамент безопасного взаимодействия с роботами?

– Во-первых, политикам и законодателям нужно проявить волю. Именно они должны создать пригодную экосреду. Всё остальное – дело техники. Инженеры решат поставленные задачи. Но, с другой стороны, это взаимная, двухсторонняя связь. Политики должны увидеть, что это реально работает, хотя бы прототипы. Вот здесь уже должны проявиться инвесторы. Если говорить о Казахстане, то я рекомендовал бы нашим законодателям принять "нейтрально-автономный статус ИИ и автономных систем". Принятый недавно закон об ИИ довольно продвинут, но он не решает проблемы разграничения ответственности. В этом законе об ИИ сейчас полностью автономные системы прямо запрещены. Причиной тому является отсутствие концептуальных, технических механизмов, в принципе способных обеспечить адекватное поведение роботов. Принятие такой новой правовой категории даст мощный толчок для развития отрасли. У Казахстана есть отличный шанс вырваться вперёд на мировой арене. Повысить свой авторитет, привлечь инвестиции, создать новые индустрии.

– Какие исследования или эксперименты вы планируете? Есть ли у вас идеи или проекты по теме предсказуемого поведения роботов?

– Первостепенной задачей на сегодня является создание и тестирование прототипов. Можно взять условную "робот-болванку" с отработанной моторикой, сенсорикой и встроить в неё предлагаемую мной архитектуру. Это может звучать просто, но на самом деле это очень трудоёмкая работа, требующая значительных ресурсов. Также стоит задача формализации "квалиа". И на данный момент есть определённые результаты в виде уравнений и параметров, описывающих динамику переживаний.

-

1🥩🥒 Сельскохозяйственная ярмарка выходного дня пройдет в Астане

-

8293

-

0

-

4

-

-

2🤩Астана — в топ-100 самых безопасных городов мира!

-

3025

-

1

-

28

-

-

3🧑⚖️ Вот это поворот! Скандал с онлайн-дневниками в школах Алматы: суд изменил решение, вынесенное в пользу Kundelik, сославшись на описку

-

2668

-

14

-

67

-

-

4📈 Повышение НДС до 16%: как это отразилось на ценах в Алматы

-

2801

-

10

-

35

-

-

5🛷 Опасная забава: какие правила безопасности нужно соблюдать на зимних горках?

-

2718

-

0

-

7

-

-

6⚠️ Доброе утро! По традиции, обзор главных новостей за 14 января

-

2451

-

0

-

3

-

-

7🚌 Общественному и дизельному транспорту запретили выезжать за пределы Астаны

-

2631

-

4

-

13

-

-

8❄️ Прогноз погоды на 15 января: сильный мороз ожидается на севере и востоке Казахстана, на юге – дожди

-

2557

-

0

-

4

-

-

9👮♀️ 10 суток ареста получил житель Астаны за разбитую остановку

-

2527

-

4

-

53

-

-

10😱 Неизвестный выстрелил из ружья в проезжавшего в машине сотрудника спецназа в Астане

-

2445

-

3

-

23

-

USD:

510.1 / 513.1

USD:

510.1 / 513.1

EUR:

594.0 / 598.0

EUR:

594.0 / 598.0

RUB:

6.43 / 6.55

RUB:

6.43 / 6.55